Miniony rok (2022) za sprawą działań głównie OpenAI dostarczył narzędzi z kategorii AI pod strzechy i wyciągnął jak zza kurtyny temat sztucznej inteligencji do mainstream’u. Najpierw w kwietniu Dall-e (generator grafiki z promptu- to słowo warto chyba dodać do słownika na stałe), później w grudniu ChatGPT3.

Myślę, że można to nazwać hype’m na AI, a przynajmniej (rodzącą się) hossą. Badania nad rozwojem uczenia maszynowego i elektronicznych sieci neuronowych mają jednak wieloletnią historię i… działające zastosowania.

Trudno było w ostatnim czasie nie usłyszeć o ChatGPT, natomiast wokół tematu prac nad AI jest cały szereg ciekawostek i potencjału, z którego warto zdawać sobie sprawę przy planowaniu pracy, kariery, inwestycji… przyszłości. Zapraszam.

Na początek kilka pojęć:

AI – AI to skrót od angielskiego pojęcia „Artificial Intelligence” – oznaczającego po polsku „sztuczną inteligencję (SI)” rzecze Google

GPT – Generative Pretrained Transformer. Silnik AI od OpenAI.

Jak piszą twórcy: GPT-3 (Generative Pretrained Transformer 3) to najnowocześniejszy model sztucznej inteligencji do przetwarzania języka opracowany przez OpenAI. Jest w stanie generować tekst podobny do ludzkiego i ma szeroki zakres zastosowań, w tym tłumaczenie języków, modelowanie języka i generowanie tekstu dla aplikacji takich jak chatboty.

“3” to oznaczenie numeru generacji, warto wiedzieć, że generacja kolejna już gdzieś tam sobie istnieje i czeka tylko na dane które mogłaby przetrawić. 😉

Dall-e – to generator grafiki na podstawie tzw. promptu. Istnieje wiele takich generatorów opartych na innych silnikach niż te AI. To tylko przykład, żeby rozwiać ewentualne poczucie, “przełomowości projektu”. Przełom nastąpił conajmniej 5 lat temu.

Prompt – to takie polecenie na podstawie, którego AI generuje dany obraz lub tekst

PaLM – Pathways Language Model. Silnik AI od google.

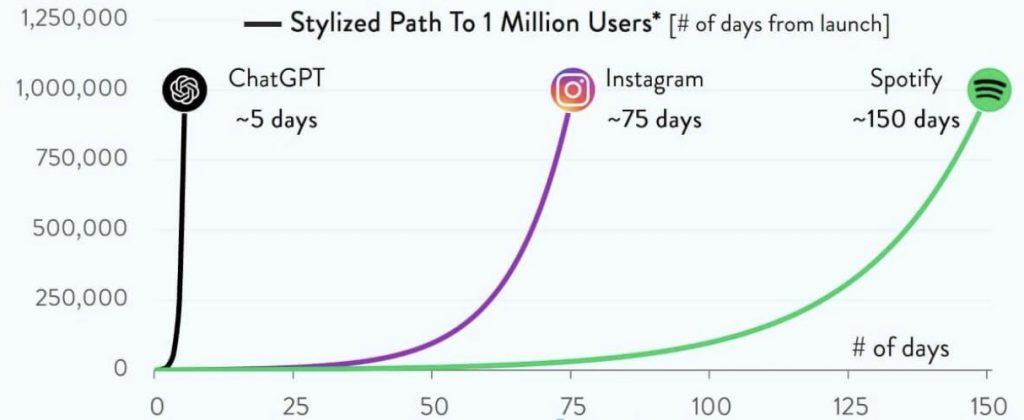

Najszybszy rajd do miliona użytkowników w historii.

W dwie minuty z wyszukiwarką Google znajdziesz listę najszybszych usług z milionem użytkowników, ChatGPT osiągnął ten poziom w kilka dni ustanawiając globalny rekord. Z perspektywy rachunku prawdopodobieństwa (z mojej ulubionej perspektywy) szansa, że będziemy coraz częściej doświadczać takich zjawisk wynosiła 100%. Wynika to z tego, że zasięg i tempo przekazu informacji wymaga infrastruktury.

Infrastruktura jaką dziś dysponujemy (internet, social media, komunikatory, mikroblogi) tworzy bezprecedensowe środowisko. Powiedzmy, że żyjemy w czasach, w których obserwujemy na żywo to co ukryte było w matematyce pod koncepcją funkcji wykładniczej i właściwościach tzw. procentu składanego oraz w naturze na umykającym codziennej percepcji poziomie. Mam na myśli podział komórkowy, rozwój płodu i praktycznie każdego organizmu żywego – wszystkie te procesy są wizualizacjami „compound interest effect”.

A co będzie jeśli AI „przeskoczy” człowieka?

Odpowiedź na to pytanie ma brzmienie: to stało się w 2017 roku. (o tym więcej innym razem) Możliwości analizy i syntezy nawet pozornie niezwiązanych danych w praktycznie każdym aspekcie do którego AI zostanie “wytrenowana”, czyli nakarmiona danymi przekraczają możliwości ludzkiego mózgu. Jednym z dobrych przykładów jest opracowana przed kilku lat metodyka rozpoznawania potencjału rozwoju choroby Parkinsona z wykorzystaniem próbki mowy. Zależności pomiędzy wynikami konwencjonalnych badań, a wnioskami z maszynowej analizy danych okazały się być oszałamiające. Uparty i dociekliwy czytelnik znajdzie więcej w sieci sam.

Darmowy ChatGPT.

Jest takie powiedzenie:

Jeśli nie wiesz skąd bierze się yield, to Ty jesteś yield’em…

Mądrości praktyczne 😉

Zrozumienie działań OpenAI ułatwia fakt, że jednym ze – zdaje się – trzech founder’ów OpenAI jest Polak – Wojciech Zaręba, który zwięźle ujmuje myśli.

Przytoczę parafrazy z niektórych jego wypowiedzi i duże uproszczenia, chciałbym, żeby przekaz był intuicyjny:

Uczenie maszynowe vs. Uczenie “po ludzku”

Człowiek uczy się ze źródła (książki, doświadczenia, innego człowieka), przeważnie “nasiąka” poglądami autora idei której się uczy. AI uczy się niejako od ludzkości, nie ocenia danych, jeśli nie wskazano klucza oceny (prompt).

Rozumienie kontekstowe.

Wyzwaniem w początkowych fazach rozwoju „silnika” było rozwiązanie kwestii rozumienia kontekstu.

Przykład – rozważmy takie dwa zdania:

1. Zjadły ciastka bo były głodne.

2. Zjadły ciastka bo były apetyczne.

Z uwagi na brak różnic w składni istnieje wyzwanie programistyczne dotyczące „ukierunkowania uwagi”. To pracujący nad AI nazywają rozumieniem kontekstowym.

Raz powodem zjedzenia ciastek był głód, innym razem „apetyczność” ciastek. Dla konwencjonalnego kodu to jest wyzwanie by potraktować każde ze zdań inaczej skoro wyglądają tak samo.

Kwestię tę udało się rozwiązać. Twórcy w wywiadach przyznają, że prace nad silnikiem o znacznie większych możliwościach są zaawansowane. OpenAI nie jest jedyną organizacją pracującą nad tego typu technologią. Ciekawe informacje docierają także z Google i ich konceptem o nazwie PaLM (Pathways Language Model).

Uczenie maszynowe.

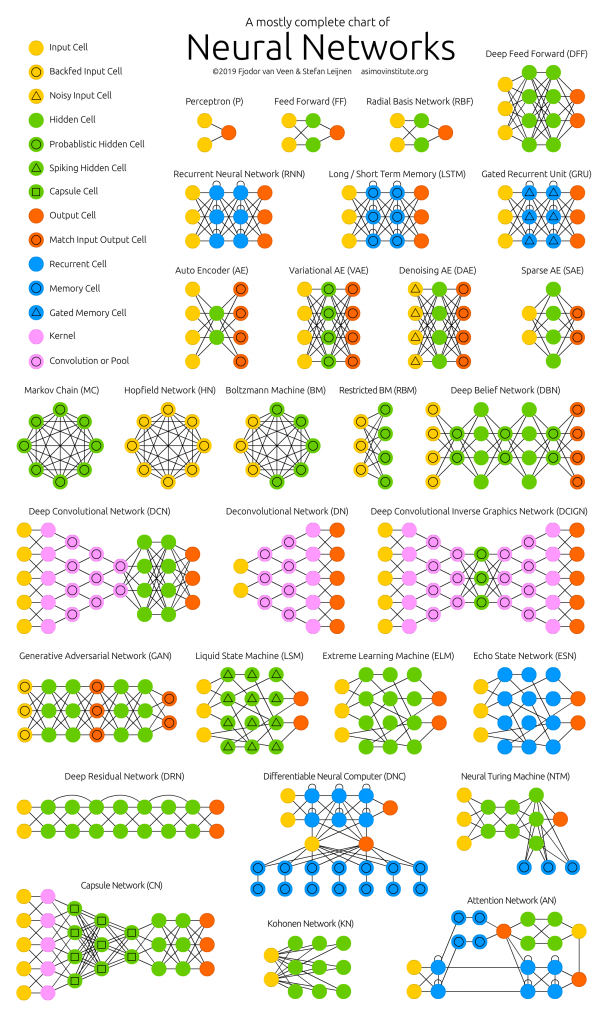

Schemat działania sieci neuronowej w dużym uproszczeniu polega na kalibrowaniu wagi (prawdopodobieństwa) danego scenariusza w drzewie możliwości na podstawie obserwacji wielu zróżnicowanych zbiorów danych.

Np. dziecko nie ma w swojej “bazie danych” wiedzy, że żelazko może być zagrożeniem. Najcześciej przypisuje podwyższone prawdopodobieństwo (podświadomie) zagrożenia po pierwszym kontakcie z rozgrzanym żelazkiem. Myślę, że w dużym uproszczeniu można tak opisać działanie tych wag, im więcej danych tym bardziej precyzyjne szacowanie prawdopodobieństwa “które rozwidlenie sieci” powinno nastąpić. Bardzo to uprościłem, zainteresowanym zalecam wejście w zagadnienie głębiej na własny rachunek. Poniżej wizualizacja koncepcji:

Produkt za darmo, czyli produktem jest użytkownik.

Miałem okazję bawić się narzędziem ChatGPT od pierwszych dni. Upłynął zaledwie miesiąc i udostępnione API oraz setki zastosowań i fakt, że całość była/jest bezpłatna spowodowały, że strona już po miesiącu jest niemal notorycznie przeciążona. Obecnie (po miesiącu) za wersję działającą względnie płynnie w czasie tego notorycznego przeciążenia trzeba już płacić (mamy jakiś zalążek modelu biznesowego). O tym na końcu.

ChatGPT nie posiada danych po 31.12.2021. Dostępne za darmo narzędzie uniemożliwia analizę danych w czasie rzeczywistym. Konieczny drobiazg. Nawet pomimo tego ograniczenia (nie)przeciętny użytkownik, na podstawie 30 minutowego filmiku z YouTube może stworzyć sobie asystenta do czytania maili i definiowania, które wymagają odpowiedzi przez pisanie dwuzdaniowych podsumowań.

W mojej ocenie darmowy dostęp do narzędzi OpenAI jest wprowadzeniem do 4 generacji silnika GPT. Dane, które można było wprowadzić do GPT-3 już tam są, teraz trenowaniem AI zajmują się użytkownicy testujący narzędzie. ChatGPT3 karmiony jest milionami promptów wbijanymi przez szybko rosnącą liczbę użytkowników co najpewniej będzie bardzo użyteczną bazą danych do nakarmienia silnika GPT-4 – który podobnie jak poprzednik będzie dostępny w okrojonej wersji lub wcale. W normalnych warunkach testerom należałoby płacić, a tu obserwujemy barter. Świetny biznesowo ruch twórców.

Wyobraź sobie polecenie np: podaj mi spółki z NASDAQ, w których wielkość obrotu wskazuje na udział insiderów (plus jeszcze kilka wymagań). Naturalnie na tzw. regulowanych rynkach w ramach sprawiedliwości i nadzoru dowiemy się jakie transakcje wykonali ludzie z C-level danej spółki, ale z odpowiednim opóźnieniem. Po kwartale np.

Czy silnik AI może generować takie informacje? Oczywiście ze może. To jest coś dużego i jeśli nie ten, to inny prawdopodobnie generuje…

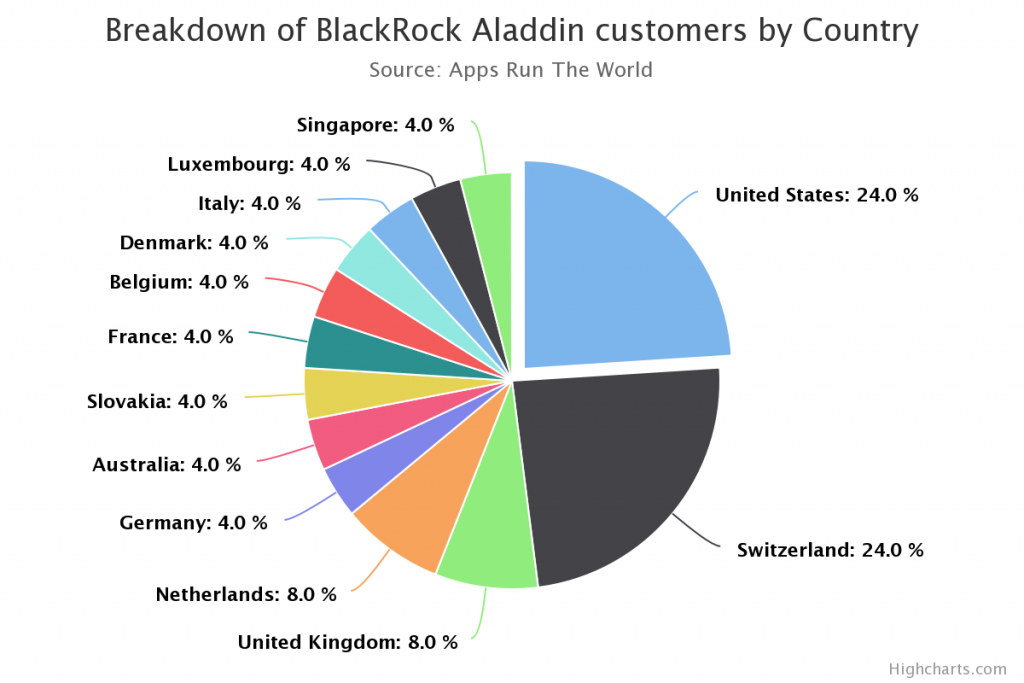

Aladdin. (AI)addin.

Aladdin. Niewiele mówi się o tym, że niemal wszyscy najwięksi gracze i zarządzający na Wall Street korzystają z oprogramowania, które wprowadził największy zarzadzający aktywami na świecie tj. BlackRock jeszcze w 1988 roku. Naturalnie można podejrzewać, że Aladdin robi to do czego został powołany z wykorzystaniem wszelkich niuansów dotyczących zbierania i syntezy danych w czasie rzeczywistym. Czyli tego czego nie ma w darmowym AI do zabawy dla Kowalskich i tego w czym AI jest wybitnie użyteczna.

Jak możemy przeczytać na stronach BlackRock:

BlackRock began to sell Aladdin in 1999. This technology is integral to who we are as a firm and is embedded in everything we do, thus differentiating us as an investment and risk manager.

oraz

Aladdin and its risk analytics are relied upon by over 200 institutions, including BlackRock. Clients include insurers, pensions, corporations, asset managers, banks, and official institutions.

Jeśli więc nie masz swojego Alladyna to występuje tu duża asymetria możliwości analizy i syntezy danych względem dużych graczy. W takiej sytuacji inwestowanie należałoby raczej nazwać grą losową i stosować narzędzia jak dla gier karcianych, ruletki itp. My w każdym razie stosujemy i daje to „szanse”, które brak dostępu do niektórych informacji zabiera.

Gdzie może pojawić się zmienność, z której można generować zysk?

Przede wszystkim, na uwagę zasługuje fakt tempa w jakim narzędzie po udostępnieniu masowemu odbiorcy się rozwija. Jeśli Bitcoin wykazywał się tzw. efektem sieciowym, to ChatGPT czy Dall-e wykazują się jeszcze większym (szybszym). Niezależnie od poglądów dotyczących Bitcoina, na pytanie czy warto było obstawić, że to „coś” może (nie)zwyczajnie szybko rosnąć odpowiedź jest raczej jednoznaczna. Wpływ na portfolio również.

OpenAI zaczynali jako organizacja non-profit, think tank. Są to jednak stare dzieje. Obecnie kapitałowo w prace „chłopaków” zaangażowane są duże brandy, wśród, których przoduje Microsoft. Tu post na TT z wczoraj (23.01.2023):

Wielu oczekuje na listowanie OpenAI na giełdach z chęcią zakupu akcji. W mojej ocenie to nie do końca właściwy kierunek. Fundamentalnie to Microsoft jest potencjalnym pierwszym beneficjentem produktów Open AI.

Dlaczego Microsoft jest typem na hossę wokół AI?

Po krótkim googlowaniu znajdziemy informacje o tym, że Microsoft już zainwestował w OpenAI ( 1mld $ w 2019 roku) i ma otrzymywać 75% zysków z OpenAI do osiągnięcia poziomu 10 mld $, po osiągnięciu tego poziomu struktura własności ma wyglądać następująco:

- 49% Microsoft

- 49% inni inwestorzy

- 2% organizacja non-profit OpenAI

Widzę tu jeszcze inne okoliczności skłaniające do stawiania Microsoftu jako pierwszego beneficjenta:

Microsoft posiada GitHub, który jest centrum rozwijania kodu wszelkiego rodzaju. Microsoft ma kreatora grafiki (Bing Image Creator) który z łatwością (tak sądzę) może być łączony z produktem OpenAI. Proszę sobie także wyobrazić (to co już jest dostępne na wielu serwisach) wystandaryzowane wsparcie AI w Wordzie, Excelu, Powerpoint czy Outlook, a także to ile urządzeń na Świecie korzysta z tego softu. W wyścigu przeglądarek – Bing mógłby zrobić duży skok dając wyniki lepsze niż te z algorytmu Google. Pamiętajmy, że Google nie stoi z boku, ma swój nieudostępniany silnik AI i prawdopodobnie również zaimplementuje do swoich usług.

Dlatego też, proszę Państwa – the winner is… Micorosft. Przy czym nie traktowałbym tego jako okazji życia do zarobienia pieniędzy – znacznie lepiej robić to z jakimś szerszym zamysłem, w ramach przemyślanego portfolio.

Mam nadzieję, że dobrze się czytało. Nie musisz zostawiać łapek w górze ani subskrybować 😉

PK

Źródła:

https://ai.googleblog.com/2022/04/pathways-language-model-palm-scaling-to.html

https://www.blackrock.com/aladdin/offerings/aladdin-overview

https://www.appsruntheworld.com/customers-database/products/view/blackrock-aladdin